달린다, 공부, 배운다, 활성화 함수

모델의 정확도를 높여주는 활성화 함수에 대해 알아보자.

- ^y(y_Hat)는 x에 대해서 표현이 가능함

- ^y(y_Hat)는 x에 대한 1차식으로 표현됨

- 수학적으로 생각해보면 인공신경망은 기본적으로 1차 결합 형태의 함수가 합성된 합성 함수의 연산이라고 볼 수 있음

- 1차식은 미분이 매우 쉽다는 장점이 있음

- 비선형적인 관계가 많기 때문에, 비선형적인 관계를 표현할 수 있도록 만든 장치가 활성화 함수임

- 은닉층(h1)에 값을 넣기 전에 활성화 함수를 한번 태운 후 넣어줌

- 각 층마다 활성화함수의 종류가 다를 수도 있음

활성화 함수란?

- 활성화 함수는 각 층의 관계를 비선형 관계로 만들어주기 때문에 기본적으로 비선형 함수임

- 선형(linear) 함수

- 직선을 의미함

- a(x) = ax + b 형태로 나타낼 수 있음

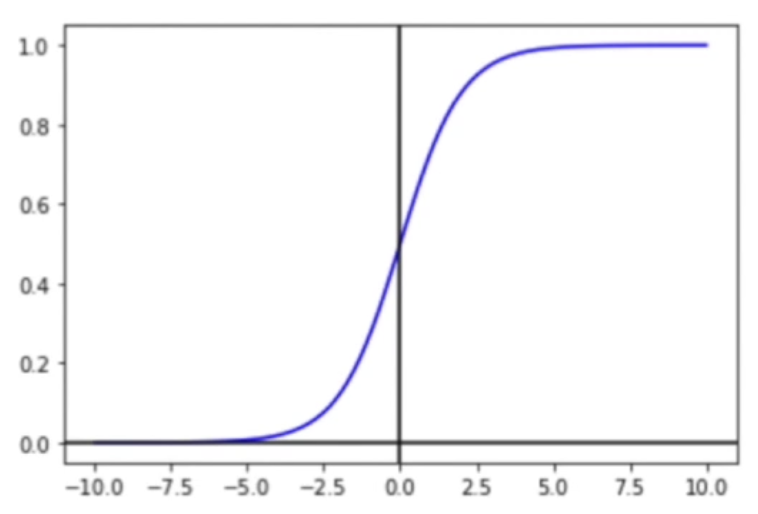

- 시그모이드(sigmoid) 함수

- 각 층의 관계를 비선형적으로 만들어줌

- 미분 가능함

- 0과 1사이의 값을 취함

- 0과 1사이의 값들로 이루어져 있기 때문에 0.5 초과면 1로 표현하고, 0.5 이하면 0으로 표현함

- 이진 분류(binary classification) 문제에 활용이 가능함

- 다중 분류 문제에서도 활용이 가능함

- 하이퍼블릭 탄젠트(tanh) 함수

- 시그모이드(sigmoid) 함수와 비슷함

- 미분 가능함

- -1 과 1 사이의 값을 취함

- 0 주변에 경사가 가파르기 때문에 미분 시 시그모이드(sigmoid) 함수보다 높은 값이 나올 수 있음

- ReLU(Rectified Linear Unit) 함수

- 가장 많이 쓰이는 활성화 함수

- 음수 값이 들어오면 0이 되고, 양수 값이 들어오면 그 값을 그대로 보냄

- 예를 들어, -2 가 들어오면 ReLU 함수를 거쳐서 0으로 내보내지고, 5가 들어오면 ReLU 함수를 거쳐서 5로 내보내 짐

- 두 개의 직선을 이어 만든 것으로 비선형 함수지만 선형과 매우 유사한 성질을 가지고 있음

- 계산이 쉽고 미분도 쉬움

- 0 지점은 미분이 불가능하기 때문에 0일 경우 어떻게 처리할지 정해줘야 함

- Leaky ReLU 함수

- 마이너스 값도 취할 수 있는 ReLU 함수

- ELU(Exponential Linear Unit) 함수

- Leaky ReLU 함수의 직선 부분을 곡선으로 변경한 함수

- 음수의 미분 값이 각 지점마다 차이가 있음

- 소프트맥스(Softmax) 함수

- 분류 문제에 최적화된 함수

- 모든 input 값들에 대해서 0과 1 사이의 값이 나옴

- 모든 성분의 합이 항상 1이 나옴 = 확률처럼 사용 가능

- 이전 노드의 값이 음수가 나오지 않게 하기 위해 항상 0과 1 사이의 값이 나오도록 함

- 선형(linear) 함수

내용에 문제가 있으면 댓글로 알려주세요!

출처 : 인프런 - 실전 인공지능으로 이어지는 딥러닝 개념 잡기(딥러닝 호형)

'딥러닝 공부' 카테고리의 다른 글

| 인공 신경망의 최적화 - 미분(Differentiation) (0) | 2021.09.23 |

|---|---|

| 인공 신경망 - 손실 함수(Regression & Classification) (0) | 2021.09.17 |

| 인공 신경망 - XOR 문제(XOR Problem) (0) | 2021.09.17 |

| 인공 신경망(Artificial Neural Networks) (0) | 2021.09.16 |

| 딥러닝 입문 (0) | 2021.09.16 |